微软亚洲研究院机器阅读系统在SQuAD挑战赛中率先超越人类水平

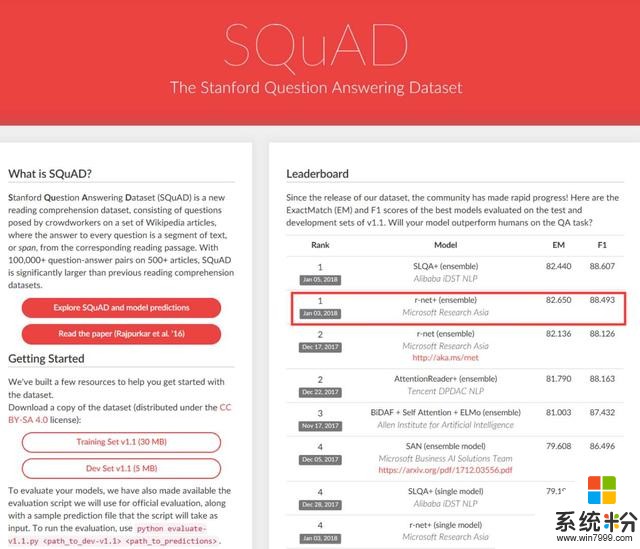

在由斯坦福大学发起的SQuAD(Stanford Question Answering Dataset)文本理解挑战赛的最新榜单上,微软亚洲研究院自然语言计算组于2018年1月3日提交的R-NET模型在EM值(Exact Match, 表示预测答案和真实答案完全匹配)上以82.650的最高分领先,并率先超越人类分数82.304。

微软亚洲研究院院长洪小文第一时间向自然语言计算组表示了祝贺:“这对于微软以及自然语言处理研究领域来说,都是一个重要的里程碑。一方面,微软团队在如此激烈的竞争中,以稳定的成绩长期位居榜首,可喜可贺。团队的最新研究成果已经应用在微软相关的AI产品中。另一方面,计算机文本理解能力首次超越人类,也预示着该领域的研究将会有更大突破,相关的AI应用普及可以期待。”

值得一提的是,最新发布的这期榜单中,阿里巴巴、腾讯、科大讯飞等中国研究团队的相关测试成绩也有大幅提升,名列榜单前列。微软亚洲研究院副院长、自然语言计算组负责人周明博士表示:“祝贺中国的自然语言理解研究已经走在世界前列!整个领域的进步需要大家共同的努力和投入来推动。自然语言处理长路漫漫,让我们共勉。”

微软亚洲研究院机器阅读团队

SQuAD挑战赛被称为机器阅读理解界的ImageNet,由斯坦福大学自然语言计算组发起,它通过众包的方式构建了一个大规模的机器阅读理解数据集(包含10万个问题),即将一篇几百(平均100,最多800)词左右的短文给标注者阅读,随后让标注人员提出最多5个基于文章内容的问题并提供正确答案。SQuAD向参赛者提供训练集用于模型训练,以及一个规模较小的数据集作为开发集,用于模型的测试和调优。与此同时,他们提供了一个开放平台供参赛者提交自己的算法,并利用测试集对其进行评分,评分结果将实时地在SQuAD官网(点击阅读原文查看)上进行更新。

得益于SQuAD所提供的庞大数据规模,参与该项挑战赛的选手不断地对成绩进行刷新,SQuAD挑战赛也逐步成为行业内公认的机器阅读理解标准水平测试,不断推动着机器阅读理解领域的发展。此前,我们曾经详细介绍过SQuAD挑战赛的具体规则,以及微软亚洲研究院自然语言计算组基于深度神经网络构建的端到端系统R-NET,感兴趣的读者可以。

你也许还想看:

,共建交流平台。来稿请寄:msraai@microsoft.com。