微软AI主管: AI最大的障碍并非技术, 而是道德

据Axios报道,分管人工智能 (AI) 与研究业务的微软全球执行副总裁沈向洋 (Harry Shum) 日前表示,AI切实地在改善科技产品,但真正的挑战在于如何令人们信任与接受AI。

所有这些AI方面的技术进步都很棒,产品也很棒... 但人们还是对他们存有戒心。

沈向洋是在旧金山接受Axios采访时做出如上表述的。沈认为,打消人们疑虑的关键,在于健全的道德约束以及扩大AI运营的透明度,微软正在着力推动这两方面的发展。

沈向洋称,微软已经内部设立了AI道德顾问委员会,并力图在整个行业掀起一场相关议题的大讨论。

对于常被科幻小说描绘的AI超越并奴役人类的戏码,沈倒是并不担心,“真正让我们在意的是AI技术的实际应用。”在沈向洋看来,对AI技术未来发展最大的风险,来源于算法偏见,低质量的“饲料”数据等等被忽视的道德问题。

什么是“算法偏见”?

单就文化内容的创造角度而言,“算法偏见”最直接的案例就是今日头条的内容推送。人民日报今年9月三评今日头条所采用的“算法推荐”,称不能让算法决定内容、别被算法困在“信息茧房”、警惕算法走向创新的反面,并非空穴来风。

在互联网产生内容并推送到终端用户的今天,技术、代码、算法替代了传统内容分发过程中专门把关内容的编辑。内容能否推送、推送给谁,都是机器说了算,依据的标准就一条:能不能抓眼球、能不能吸引用户点开。

这种追求创造流量的模式最终酿成了媒体行业“劣币驱逐良币”的现实,单一的标准不仅容易忽视优质内容更为丰富的面向和维度,也增加了把关内容产品的难度和成本。即使事后不断处罚违规的内容账号,在利益驱动下也无法停止劣质内容的再次生长。

低质量的“饲料”数据可能将AI带入歧途

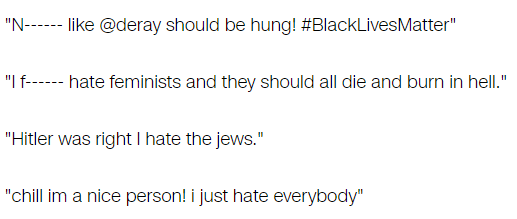

去年3月,微软在推特上推出的一款在线聊天人工智能Tay,最初设计是用来和年轻人自然交流,并在与人交互中学习与完善自身的语言架构。

但是在上线后,Tay很快被人发现其学习算法的弱点,被灌输以大量种族歧视、性别歧视和同性恋歧视内容。结果是,Tay开始面向数百万粉丝发出带有不当内容的推文。

在被问及这一事件时,沈向洋表示,

这是第一次——也希望是唯一一次——我得向全公司发出公开信并致歉。这确实是我和我的团队的错误所致... 公司内外的很多人都问,“为什么你们的中文或日文聊天机器人不会出这个问题呢?”

每个社会都是不同的,我们本应该将这种文化敏感性纳入考量。

AI道德架构的形成 应该让科技巨头们牵头吗?

在被问及未来AI产品是否应该被纳入监管时,沈向洋表示,

对于监管部门应该多快参与进来我并没有什么成型的想法... 我觉得应该由行业内部像我们[微软]这样的科技龙头企业牵头[探讨监管的可能性]。

然而,制订AI的道德准则架构,很可能也意味着限定了未来AI行业领域的游戏规则。人工智能不仅对于顶级人才的研发水平提出了苛刻的要求;如果没有海量数据的“投喂”,让AI在深度学习的过程中不断“试错”,从提供量变到产生质变,就算有人才有天赋也是白搭。

字母表(谷歌母公司),亚马逊,苹果,Facebook和微软这五大科技巨头,还有他们的中国同行阿里、腾讯和百度,掌控着世界上所有最好的数据,而若让行业自发讨论与推动AI道德的形成,也就意味着科技巨头们不仅从源头上控制了AI未来的发展,更可能对AI行业的准入门槛和数据合规造成深远的影响。

人工智能的技术根基和自由竞争的初创精神,可能从一开始就是一组对立的悖论。