如何纠正AI偏见? 微软从小孩子的思维习惯和游戏中总结出5种方法

【智能观】如何识别AI产生的偏见呢?微软包容性设计团队发现,培养AI和培养小孩子如出一辙,而孩子童年玩游戏中表现出的一些无意识的偏见和AI产生的偏见也很想象。因此,他们通过研究小孩子玩游戏提出五种识别AI偏见的方法,并提供了这份指南。

话说有一天,X学校开始使用面部识别软件记录考勤,登陆在线作业系统。但是软件有一个bug,它的制造者只使用了浅肤色人群的测试样本来训练算法。不幸的是,你恰好是名非裔学生。由于肤色的原因,软件很难识别你,因此,它判你上课迟到,说你没有按时完成作业。软件怎么会出错呢?受到影响的只有你的成绩。

曾有人疑惑,人工智能是怎么成为种族主义者的呢?上述就是人工智能对肤色歧视的例子。虽然这并不是真实案例,但类似的人工智能偏见已经在科技行业和社交媒体上饱受诟病。

科技行业现在一谈人工智能就很high,大数据和机器学习给了人们几年前难以想象的强大体验。但AI想要完美地实现人们的愿景,其系统必须是值得信赖的。因为人们的信任越多,他们与系统的交互就越多,系统就会获得更多数据,得到更好的结果。但信任需要很长时间才能建立,偏见却可以瞬间将其摧毁。

认识人工智能的排外行为

人工智能的确会出现偏见,除非从它设计之初就有比较完善的模型。创建包容性的人工智能最关键的一步是认识到偏见是如何影响系统的。

包容性设计的首要原则是确认排外行为,本文也将AI偏见分为不同的类别,方便产品制造者及早发现问题,预见未来会出现的问题,并做出更好的决策。借助本文,AI团队可以清楚地看到自己的系统哪里出了问题,这样他们就能识别偏见,并积累经验,实现AI对每个人都公平的承诺。

五种识别偏见的方法

我们与学术界、制造业的一些思想领袖合作,确定了五种识别偏见的方法。接下来,我们会使用孩子们的经历来解释这些行为。为什么把AI产生的偏见和孩子童年产生的偏见联系在一起呢?其实这是一个很好的比喻:人工智能正处于起步阶段,就像孩子一样,它如何成长,取决于我们如何培养和培育它。

每一个偏见类别都有一个童年隐喻,包括定义、产品示例,以及团队和AI工作面临的压力测试。

1. 数据集的偏见

年幼的孩子会认为自己眼中看到的就是整个世界。渐渐地,世界上的大部分信息都在他们的视野之外。这是数据集偏见的根源:信息太少、太单一。

定义:用于培训机器学习模型的数据无法代表基础用户的多样性。大型数据集是人工智能的基础。与此同时,数据集常常被简化成一般化的理想模型,不能充分考虑用户的特殊性,因此代表不了全体用户。

产品示例:机器视觉技术,如跟踪用户移动的网络摄像头,只能用于部分群体(主要是白人),因为最初的训练数据排除了其他种族和肤色。

压力测试:你使用的训练集是否包括客户群中的每一个人? 如果没有,你是否测试了与样本无关的用户数据?你的AI团队中的其他人怎么样?他们是包容的、多样化的、对识别偏见敏感的人吗?

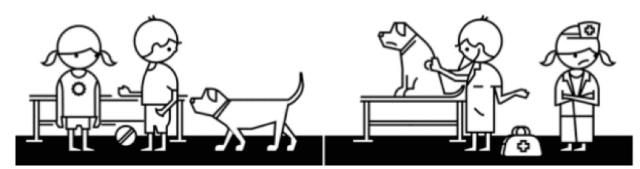

2. 联想的偏见

还记得孩子们喜欢的 “医生护士”的游戏吗?一些男孩喜欢当医生,他们认为女孩应该去当护士。女孩如果也想当医生就必须推翻男孩的联想:“嘿,女孩也可以是医生!”

定义:用于培训AI模型的数据中增加或增强了一种文化偏见。在训练人工智能算法时,人类偏见可对机器学习产生影响。在未来的人机互动中如果继续保持这些偏见,可能会导致不公平的用户体验。

产品示例:以性别假设工作的语言翻译工具。它认为飞行员是男性,空乘人员是女性。

压力测试: 你的训练结果是否让团队定性了性别或种族?你能做什么打破机器不健康、不公平的联想?你的数据集已经分类并贴上标签了吗?

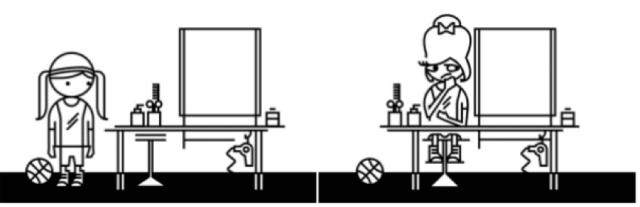

3. 自动化的偏见

有的女孩喜欢运动,喜欢自然的外表,讨厌任何做作的东西。但美容师并不认为她这样很美,于是给她改头换面,用上大量化妆品,打造复杂的发型。结果美容师很高兴,被打扮的女孩却感到恐惧。

定义:AI自动决策超越了人类社会和文化因素。预测程序自动实现的目标违背了人类多样性。这些算法并不是从对人类负责的角度做出决定的,而是受到人类的影响做出决定。AI设计师和从业人员需要考虑他们所构建的系统是否影响人的决策。

产品示例:美图软件中的滤镜强化了欧洲人对美容的观念,如减轻肤色。

压力测试:多样化的用户是否同意你的算法得出的结论?你的AI系统是否越权,排除人类选择,让人们去支持自动决策?你如何确保AI系统中一直有人的观点?

4. 交互的偏见

“打电话”是一个很受孩子们欢迎的游戏。第一个人先对第二个人贴耳低声说一句话,然后第二个人再这样传话给第三个人……直到最后一个人说出他所听到的。这个游戏的目的是正确地在多个环节中传递信息。如果其中一个孩子故意变个说法,创造了错误的结果,最终可能引来大家的捧腹大笑。看起来很有趣,但现实中出现这种情况可能会让我们精神崩溃。

定义:人们刻意篡改人工智能并令其产生带有偏见的结果。现在的聊天机器人就可以开玩笑,愚弄人们,让人们感觉它们是人类。但这些试图将人工智能人性化的尝试,却无意中给电脑程序带来了许多有害的人类偏见。当聊天机器人在没有约束的情况下相互动态学习时,产生的交互偏见就会越来越大。

产品例子:被人们灌输了种族主义或性别歧视意识的聊天机器人,被训练得可以说出攻击性言论。

压力测试: 你是否已经仔细检查过系统中没有恶意篡改的倾向?你的人工智能系统向人们学到了什么?你只是单纯设计了实时互动和学习吗?你知道这意味着什么吗?

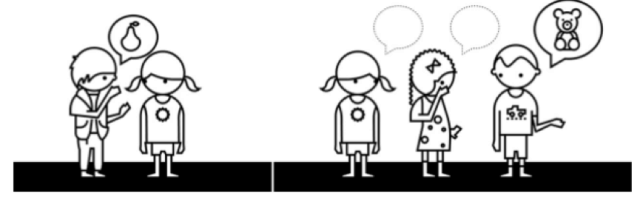

5. 认识上的偏见

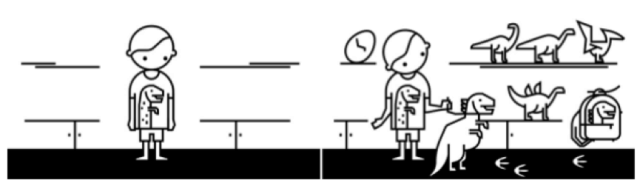

如果孩子买了一件恐龙玩具,他的爷爷奶奶姥姥姥爷七大姑八大姨看到了,以为他喜欢,就会去给他买更多的恐龙玩具。没过几年,亲戚朋友都以为这孩子是恐龙玩具的“脑残粉”,又给他不停地买买买,直到装不下为止。

定义:简单粗暴的个性化会对一个群体或个人产生偏见。认识上的偏见会以一种先入为主的方式来解释信息。一旦AI算法提供的内容与用户某次不经意的选择相匹配,那用户就看不到别的不匹配结果了。接受AI推荐的人永远看不到那些与自己三观不同的观点,同时也看不到被AI屏蔽了的替代方案和不同的想法。

产品示例:含有产品推荐的购物网站,总是推荐人们已经购买过的东西。

压力测试:你的算法是否建立并强化只有流行偏好?随着客户的不断变化,你的AI系统能否根据用户的改变动态演进?你的AI系统能否帮助客户对世界有更多元、更包容的看法?

如何使用以上指南

作为人工智能产品体验的设计者和创造者,我们需要深思人工智能的发展以及它如何影响真实的人。上述指南只是为每个人提供平等体验的开始。

如果把这些想法用到文章开篇的例子中,就可以把这件事标记为数据集偏见:软件接受的数据太片面。通过认识和理解这些偏见,我们可以测试系统与人类思维的差别,并建立更具包容性的体验。我们的面部识别软件是否受制于故意导入的错误数据?还有哪些偏见会影响产品体验?

在人工智能领域工作的大多数人都遇到过偏见问题。不过令人尴尬的是,无意识的偏见会产生令人不快的结果,尽管我们都想识别和避免。本文的目标就是帮助你识别导致这种情况的潜在偏见。通过上述方法测试你大脑中是否产生过这些偏见,这样你就可以专心地将AI的潜力传递给所有的用户了。

—完—