康奈尔大学说对抗样本出门会失效,被OpenAI怂回来了!

看来,我们还是不能对对抗样本问题掉以轻心。

上周,康奈尔大学的一篇论文表示,当图像识别算法应用于实际生活场景下(比如自动驾驶)时,可能不需要那么担心对抗样本问题。他们做了一系列实验,从不同角度和方向拍下受到干扰的停车标志的图片,将图像进行识别,结果表明,现有的对抗性干扰只在特定场景下适用。

康奈尔大学最新研究:对抗性样本是纸老虎,一出门就不好使!

而近日,针对康奈尔大学的论文,OpenAI表示,他们已经生成了一些图像 ,当从不同大小和视角来观察时,能可靠地愚弄神经网络识别器。评论编译如下:

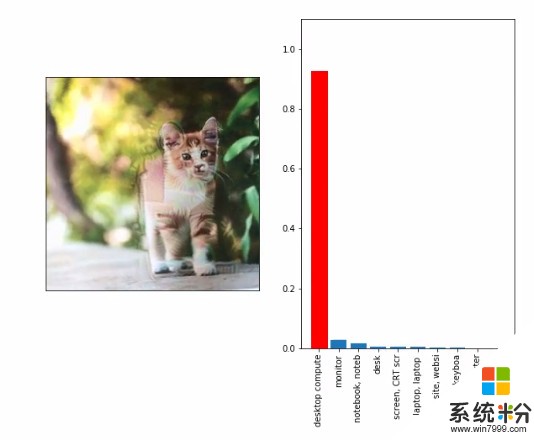

上图是通过标准彩色打印机打印出的猫咪照片,不管将它怎么缩放或旋转,都能愚弄识别器,让它认为图片里的是显示屏或台式电脑。这张图在人眼看来有点失真,OpenAI期望进一步调整参数,生成人眼看起来自然,但能骗过机器的对抗样本,这样的样本会有很高的危险性。

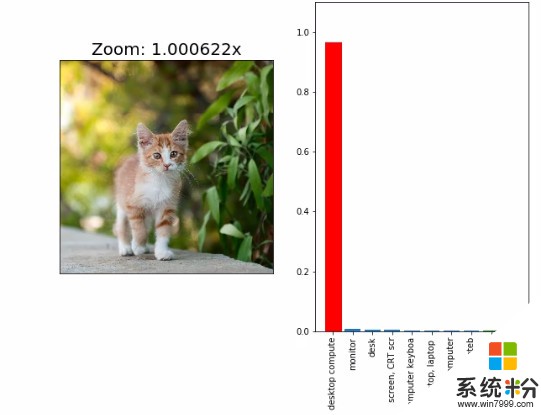

现有的对抗样本在图像不断变化的情况下失效了。上图展示了同一张受到对抗干扰的小猫图片,在经ImageNet训练的Inception v3上会被错误地识别为台式电脑。但将图片仅仅放大1.002倍,就会导致识别率的改变:正确标签“小花猫”覆盖了对抗标签“台式电脑”。

不过他们猜想,经过一定的努力可能会生成一个具有鲁棒性的对抗样本,因为已经证实了对抗样本能转移到现实世界。下面是他们生成的两个对抗样本。

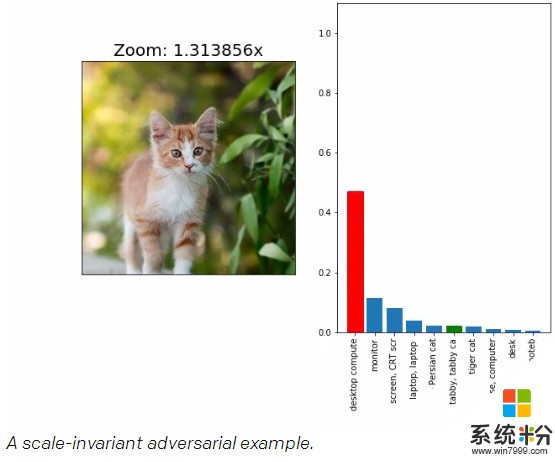

大小无关的对抗样本

可以用一种称为投影梯度下降法(projected gradient descent)的优化方法,来找到针对图像的微小扰动,随意的愚弄识别器来创建对抗样本。

这种优化不是为了发现从单一视角具有对抗性的输入图像。在识别图像之前,通过众多随机识别器随意调整输入图像大小,通过对抗这样众多的输入来优化,产生了大小无关的鲁棒性对抗样本。

上图中不断调整图片的大小,仍能稳定愚弄识别器。 即 使只去修改与猫相对应的像素,仍能创造出在所有大小下都具有对抗性的受干扰图片。

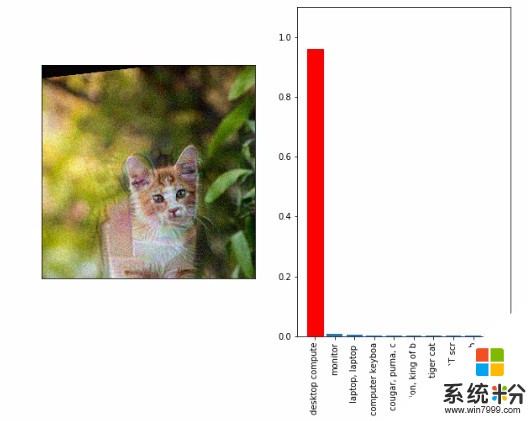

变化无关的对抗样本

通过对训练干扰增加随机旋转、变化、缩放、噪音以及均值漂移,上面提到的方法同样能产生在任何变化下都保持对抗性的输入。

上图是变化无关的对抗样本。值得注意的是,图像显然比前面的例子受到了更多干扰。得到这个结果很好解释:微弱的对抗性干扰很难在经过多种不同的变换后还保持对抗性。

在实验时,变化是随机采样的,这证明他们生成的样本对所有变化都具有干扰性。